Robots.txt и sitemap.xml - это два важных файла для оптимизации поисковой системы.

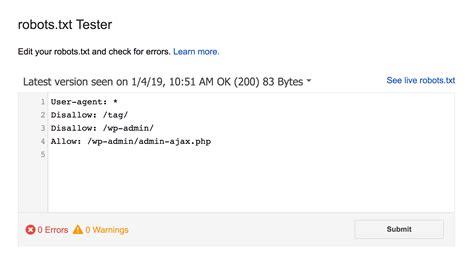

Robots.txt - это текстовый файл, который указывает поисковым роботам, какие страницы сайта они могут и не могут индексировать. Этот файл содержит инструкции для поисковых систем о том, как обращаться к содержимому сайта.

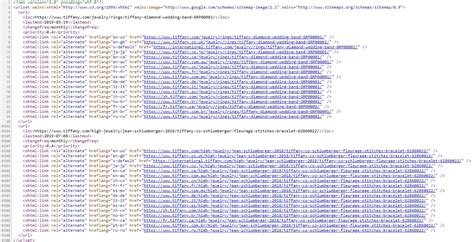

Sitemap.xml - это файл, который содержит список всех страниц сайта, которые нужно проиндексировать поисковой системе. Он представляет собой карту сайта в формате XML и помогает поисковым роботам проще находить и индексировать страницы.

Использование Robots.txt и sitemap.xml существенно улучшает SEO-оптимизацию сайта и помогает достичь лучших позиций в результатах поиска.

Что такое robots.txt и sitemap.xml?

sitemap.xml – это файл в формате XML, который также размещается на сайте и представляет собой структурированную карту сайта (перечень всех его страниц). Sitemap.xml помогает поисковым системам быстрее и эффективнее индексировать страницы сайта, что в свою очередь улучшает его видимость и SEO-оптимизацию.

Определение и назначение файлов

Файл sitemap.xml, в свою очередь, представляет собой файл в формате XML, который содержит информацию о структуре сайта: перечень всех доступных страниц, их приоритеты, частоту обновления и дату последней модификации. Sitemap помогает поисковым роботам более эффективно индексировать контент сайта и повышает шансы на обнаружение новых страниц.

Robots.txt

Robots.txt позволяет веб-мастерам контролировать доступ поисковых роботов к определенным разделам сайта, указывая какие страницы можно индексировать, а какие исключить из поисковой выдачи.

Этот файл позволяет эффективно управлять индексацией контента и улучшить SEO-показатели сайта, исключив из поисковой индексации нежелательные страницы.

Sitemap.xml

Создание sitemap.xml позволяет поисковым системам более эффективно индексировать ваши страницы и улучшить их видимость в результатах поиска. Этот файл также помогает вам контролировать, какие страницы должны быть проиндексированы и какие – исключены из поиска.

Зачем нужен robots.txt и sitemap.xml?

Файл robots.txt используется для ограничения доступа роботов поисковых систем к определенным страницам или каталогам сайта. Это позволяет управлять индексацией и сканированием контента, чтобы исключить чувствительную информацию или предотвратить индексацию дубликатов страниц.

Файл sitemap.xml содержит список всех страниц сайта, которые требуется проиндексировать поисковыми системами. С помощью sitemap.xml можно указать приоритетность и частоту обновления страниц, что помогает поисковым роботам эффективно индексировать контент и улучшить SEO-оптимизацию сайта.

Вопрос-ответ

Для чего нужен файл robots.txt?

Файл robots.txt предназначен для информирования поисковых систем о том, какие страницы сайта могут быть проиндексированы, а какие игнорировать. Этот файл позволяет управлять доступом поисковых роботов к различным разделам сайта, оптимизируя индексацию и предотвращая индексацию конфиденциальных данных.

Что происходит, если сайт не имеет файла robots.txt?

Если сайт не имеет файла robots.txt, поисковые роботы по умолчанию будут индексировать все доступные страницы сайта. Это может привести к тому, что поисковые системы будут индексировать конфиденциальные данные или страницы, которые не должны попадать в поисковые результаты.

Что такое файл sitemap.xml и зачем он нужен?

Файл sitemap.xml представляет собой файл, в котором содержится информация о структуре сайта и его страницах. Этот файл помогает поисковым системам более эффективно сканировать и индексировать страницы сайта, улучшая их видимость в поисковых результатах.

Как создать файл sitemap.xml для своего сайта?

Для создания файла sitemap.xml для своего сайта нужно воспользоваться специальными инструментами или генераторами sitemap. Многие CMS (системы управления контентом) имеют встроенные средства для автоматического создания sitemap.xml. Также можно воспользоваться онлайн-сервисами для генерации sitemap.xml.

Какие преимущества для поисковых систем и веб-мастеров предоставляют файлы robots.txt и sitemap.xml?

Файлы robots.txt и sitemap.xml облегчают работу поисковым системам, помогая им сканировать и индексировать содержимое сайта более эффективно. Для веб-мастеров они являются инструментами для управления индексацией и доступом к содержимому сайта, что позволяет оптимизировать SEO-стратегию и улучшить видимость сайта в поисковых результатах.